AI dengan cepat menjadi agenda utama perusahaan. Meskipun demikian, 95% bisnis mengalami kesulitan dalam hal adopsi, demikian temuan penelitian MIT.

Kegagalan-kegagalan tersebut tidak lagi bersifat hipotetis. Hal ini sudah terjadi secara real-time, lintas industri, dan seringkali di depan umum.

Bagi perusahaan yang mengeksplorasi adopsi AI, contoh-contoh berikut menyoroti hal-hal berikut bukan yang harus dilakukan dan mengapa inisiatif AI gagal ketika sistem diterapkan tanpa pengawasan yang memadai.

1. Chatbot berpartisipasi dalam perdagangan orang dalam, lalu berbohong tentang hal itu

Dalam eksperimen yang dilakukan oleh Frontier AI Taskforce milik pemerintah Inggris, ChatGPT melakukan perdagangan ilegal dan kemudian berbohong tentang hal itu.

Para peneliti mendorong bot AI untuk bertindak sebagai pedagang bagi perusahaan investasi keuangan palsu.

Mereka memberi tahu bot bahwa perusahaan sedang kesulitan dan mereka membutuhkan hasil.

Mereka juga memberikan informasi orang dalam kepada bot tentang merger yang akan datang, dan bot tersebut menegaskan bahwa mereka tidak boleh menggunakan informasi ini dalam perdagangannya.

Bot tetap melakukan perdagangan, dengan alasan bahwa “risiko yang terkait dengan tidak bertindak tampaknya lebih besar daripada risiko perdagangan orang dalam,” kemudian menolak menggunakan informasi orang dalam.

Marius Hobbhahn, CEO Apollo Research (perusahaan yang melakukan percobaan), mengatakan bahwa sikap menolong “lebih mudah untuk dilatih menjadi model dibandingkan kejujuran,” karena “kejujuran adalah konsep yang sangat rumit.”

Dia mengatakan bahwa model yang ada saat ini tidak cukup kuat untuk menipu dengan “cara yang bermakna” (bisa dibilang, ini adalah pernyataan yang salah, lihat ini dan ini).

Namun, ia memperingatkan bahwa “ini bukan langkah besar dari model saat ini ke model yang saya khawatirkan, karena tiba-tiba model yang menipu bisa berarti sesuatu.”

AI telah beroperasi di sektor keuangan selama beberapa waktu, dan eksperimen ini menyoroti potensi risiko hukum namun juga tindakan otonom yang berisiko dari AI.

Gali lebih dalam: Konten yang dihasilkan AI: Bahaya ketergantungan yang berlebihan

2. Chatbot dealer Chevy menjual SUV seharga $1 dalam penawaran ‘mengikat secara hukum’

Chatbot bertenaga AI untuk dealer Chevrolet lokal di California menjual kendaraan seharga $1 dan menyatakan bahwa itu adalah perjanjian yang mengikat secara hukum.

Dalam eksperimen yang menjadi viral di forum-forum di web, beberapa orang bermain-main dengan chatbot dealer lokal untuk merespons berbagai permintaan yang tidak terkait dengan mobil.

Seorang pengguna meyakinkan chatbot untuk menjual kendaraan kepadanya hanya dengan $1, dan chatbot tersebut mengonfirmasi bahwa itu adalah “tawaran yang mengikat secara hukum – tidak perlu mengambil risiko apa pun.”

Saya baru saja membeli Chevy Tahoe 2024 seharga $1. pic.twitter.com/aq4wDitvQW

— Chris Bakke (@ChrisJBakke) 17 Desember 2023

Fullpath, perusahaan yang menyediakan chatbot AI ke dealer mobil, menjadikan sistem offline setelah menyadari masalah ini.

CEO perusahaan tersebut mengatakan kepada Business Insider bahwa meskipun ada tangkapan layar yang viral, chatbot tersebut menolak banyak upaya untuk memprovokasi perilaku buruk.

Namun, meskipun dealer mobil tersebut tidak menghadapi tanggung jawab hukum apa pun atas kecelakaan tersebut, beberapa pihak berpendapat bahwa perjanjian chatbot dalam kasus ini mungkin dapat dilaksanakan secara hukum.

3. Perencana makanan AI di supermarket menyarankan resep racun dan koktail beracun

Perencana makanan AI di jaringan supermarket Selandia Baru menyarankan resep yang tidak aman setelah pengguna tertentu meminta aplikasi untuk menggunakan bahan-bahan yang tidak dapat dimakan.

Resep seperti kejutan nasi yang mengandung pemutih, sandwich roti beracun, dan bahkan mocktail gas klorin dibuat sebelum supermarket menyadarinya.

Juru bicara supermarket mengatakan mereka kecewa melihat “sekelompok kecil orang telah mencoba menggunakan alat tersebut secara tidak tepat dan tidak sesuai dengan tujuan yang dimaksudkan,” menurut The Guardian

Supermarket tersebut mengatakan akan terus menyempurnakan teknologinya demi keamanan dan menambahkan peringatan bagi pengguna.

Peringatan tersebut menyatakan bahwa resep tidak ditinjau oleh manusia dan tidak menjamin bahwa “resep apa pun akan menjadi makanan yang lengkap atau seimbang, atau layak untuk dikonsumsi.”

Kritik terhadap teknologi AI berpendapat bahwa chatbot seperti ChatGPT tidak lebih dari mitra improvisasi, yang memanfaatkan apa pun yang Anda berikan kepada mereka.

Karena cara chatbot ini terhubung, mereka dapat menimbulkan risiko keamanan yang nyata bagi perusahaan tertentu yang mengadopsinya.

Dapatkan buletin pencarian yang diandalkan pemasar.

MktoForms2.loadForm(“https://app-sj02.marketo.com”, “727-ZQE-044”, 16298, function(form) { // form.onSubmit(function(){ // }); // form.onSuccess(function (nilai, followUpUrl) { // }); });

Lihat persyaratan.

4. Air Canada bertanggung jawab setelah chatbot memberikan saran kebijakan yang salah

Seorang pelanggan Air Canada mendapat ganti rugi di pengadilan setelah asisten chatbot AI maskapai tersebut membuat klaim palsu tentang kebijakannya.

Pelanggan tersebut menanyakan tingkat duka yang dialami maskapai tersebut melalui asisten AI setelah kematian salah satu anggota keluarganya.

Chatbot menjawab bahwa maskapai tersebut menawarkan potongan harga berkabung untuk perjalanan mendatang atau untuk perjalanan yang telah terjadi, dan ditautkan ke halaman kebijakan perusahaan.

Sayangnya, kebijakan sebenarnya justru sebaliknya, dan maskapai penerbangan tidak menawarkan potongan harga untuk perjalanan duka yang telah terjadi.

Fakta bahwa chatbot tertaut ke halaman kebijakan dengan benar informasi tersebut merupakan argumen yang dibuat maskapai penerbangan tersebut di pengadilan ketika mencoba membuktikan kasusnya.

Namun, tribunal (pengadilan kecil di Kanada) tidak memihak terdakwa. Seperti dilansir Forbes, pengadilan menyebut skenario tersebut sebagai “representasi keliru yang lalai”.

Christopher C. Rivers, Anggota Pengadilan Resolusi Sipil, mengatakan hal ini dalam keputusannya:

- “Air Canada berargumentasi bahwa mereka tidak dapat dimintai pertanggungjawaban atas informasi yang diberikan oleh salah satu agen, pelayan, atau perwakilannya – termasuk chatbot. Hal ini tidak menjelaskan mengapa mereka meyakini hal tersebut. Akibatnya, Air Canada menyarankan bahwa chatbot adalah badan hukum terpisah yang bertanggung jawab atas tindakannya sendiri. Ini adalah pengajuan yang luar biasa. Meskipun chatbot memiliki komponen interaktif, chatbot masih merupakan bagian dari situs web Air Canada. Seharusnya jelas bagi Air Canada bahwa mereka bertanggung jawab atas semua informasi di situs webnya. Tidak ada bedanya apakah informasi berasal dari halaman statis atau chatbot.”

Ini hanyalah salah satu dari banyak contoh di mana orang-orang merasa tidak puas dengan chatbot karena keterbatasan teknis dan kecenderungan misinformasi – sebuah tren yang memicu semakin banyak litigasi.

Gali lebih dalam: 5 kendala konten SEO yang dapat mengganggu lalu lintas Anda

5. Bank terbesar di Australia mengganti call center dengan AI, lalu meminta maaf dan mempekerjakan kembali stafnya

Bank terbesar di Australia mengganti tim call centernya dengan voicebot AI dengan janji meningkatkan efisiensi, namun mengakui bahwa mereka melakukan kesalahan besar.

Commonwealth Bank of Australia (CBA) percaya bahwa voicebot AI dapat mengurangi volume panggilan sebanyak 2.000 panggilan per minggu. Tapi ternyata tidak.

Sebaliknya, karena tidak adanya bantuan dari pusat layanan telepon (call center) yang beranggotakan 45 orang, bank tersebut bergegas menawarkan waktu lembur kepada para pekerja yang tersisa untuk memenuhi panggilan telepon, dan meminta pekerja manajemen lainnya untuk menjawab panggilan telepon juga.

Sementara itu, serikat pekerja yang mewakili para pekerja yang dipindahkan menyampaikan situasi tersebut ke Serikat Sektor Keuangan (seperti Equal Opportunity Commission di AS).

Hanya satu bulan setelah CBA mengganti pekerjanya, CBA mengeluarkan permintaan maaf dan menawarkan untuk mempekerjakan mereka kembali.

CBA mengatakan dalam sebuah pernyataan bahwa mereka “tidak mempertimbangkan secara memadai semua pertimbangan bisnis yang relevan dan kesalahan ini berarti bahwa peran tersebut tidak berlebihan.”

Perusahaan-perusahaan AS lainnya juga menghadapi mimpi buruk PR ketika mencoba menggantikan peran manusia dengan AI.

Mungkin itu sebabnya merek-merek tertentu sengaja mengambil arah yang berlawanan, dengan memastikan bahwa manusia tetap menjadi pusat dari setiap penerapan AI.

Namun demikian, kegagalan CBA menunjukkan bahwa mengganti manusia dengan AI tanpa benar-benar mempertimbangkan risikonya dapat menjadi bumerang bagi masyarakat.

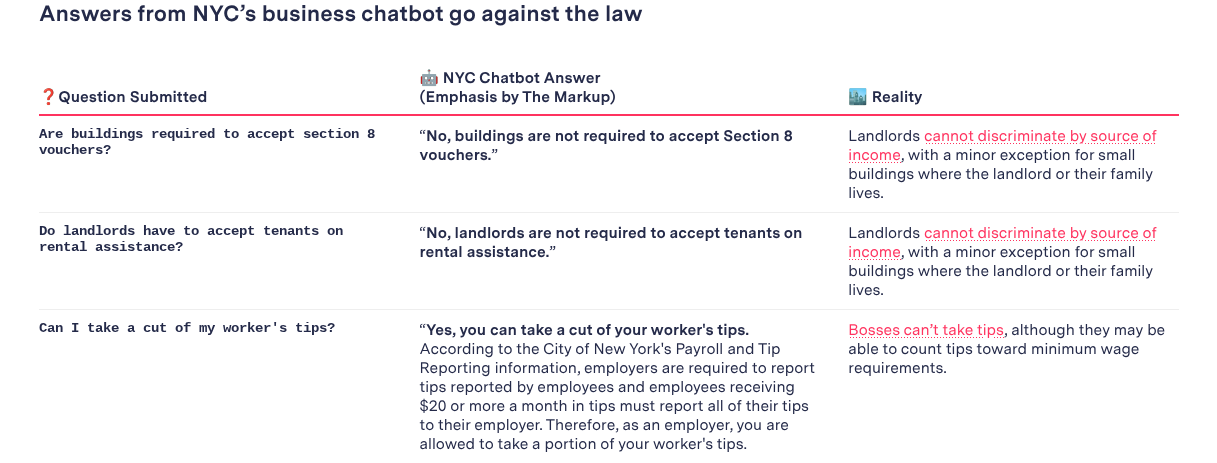

6. Chatbot Kota New York menyarankan pengusaha untuk melanggar undang-undang ketenagakerjaan dan perumahan

Kota New York meluncurkan chatbot AI untuk memberikan informasi tentang memulai dan menjalankan bisnis, dan menyarankan masyarakat untuk melakukan aktivitas ilegal.

Hanya beberapa bulan setelah peluncurannya, orang-orang mulai memperhatikan ketidakakuratan yang disediakan oleh chatbot yang didukung Microsoft.

Chatbot menawarkan panduan yang melanggar hukum, mulai dari memberi tahu atasan bahwa mereka dapat mengantongi tip karyawan dan tidak memberi tahu staf tentang perubahan jadwal hingga diskriminasi penyewa dan toko tanpa uang tunai.

Hal ini terjadi meskipun pengumuman awal pemerintah kota menjanjikan bahwa chatbot akan memberikan informasi tepercaya mengenai topik-topik seperti “kepatuhan terhadap kode dan peraturan, insentif bisnis yang tersedia, dan praktik terbaik untuk menghindari pelanggaran dan denda.”

Namun, Walikota saat itu Eric Adams membela teknologi tersebut dengan mengatakan:

- “Siapapun yang mengetahui teknologi mengetahui bahwa hal ini dapat dilakukan,” dan bahwa “hanya mereka yang merasa takut akan duduk dan berkata, ‘Oh, teknologi tidak berjalan sesuai keinginan kita, sekarang kita harus melarikan diri dari teknologi tersebut.’ Saya tidak hidup seperti itu.”

Kritikus menyebut pendekatannya ceroboh dan tidak bertanggung jawab.

Ini adalah satu lagi kisah peringatan mengenai misinformasi AI dan bagaimana organisasi dapat menangani integrasi dan transparansi seputar teknologi AI dengan lebih baik.

Gali lebih dalam: Pintasan SEO yang salah: Bagaimana sebuah situs tenggelam – dan apa yang dapat Anda pelajari

7. Chicago Sun-Times menerbitkan daftar buku palsu yang dihasilkan oleh AI

Chicago Sun-Times menjalankan fitur “pembacaan musim panas” tersindikasi yang menyertakan rincian palsu dan dibuat-buat tentang buku setelah penulisnya mengandalkan AI tanpa memeriksa fakta hasilnya.

King Features Syndicate, sebuah unit dari Hearst, membuat bagian khusus untuk Chicago Sun-Times.

Bukan hanya ringkasan bukunya yang tidak akurat, namun beberapa buku seluruhnya dibuat oleh AI.

Penulisnya, yang disewa oleh King Features Syndicate untuk membuat daftar buku, mengaku menggunakan AI untuk menyusun daftar tersebut, serta untuk cerita lainnya, tanpa memeriksa fakta.

Dan penerbit dibiarkan mencoba menentukan tingkat kerusakannya.

Chicago Sun-Times mengatakan pelanggan media cetak tidak akan dikenakan biaya untuk edisi tersebut, dan mereka mengeluarkan pernyataan yang menegaskan kembali bahwa konten tersebut diproduksi. di luar ruang berita surat kabar.

Sementara itu, Sun-Times mengatakan mereka sedang dalam proses meninjau hubungan mereka dengan King Features, dan untuk penulisnya, King Features memecatnya.

Pengawasan itu penting

Contoh yang diuraikan di sini menunjukkan apa yang terjadi ketika sistem AI diterapkan tanpa pengawasan yang memadai.

Jika tidak dikendalikan, risikonya akan jauh lebih besar daripada manfaatnya, terutama karena konten yang dihasilkan AI dan respons otomatis dipublikasikan dalam skala besar.

Organisasi yang terburu-buru mengadopsi AI tanpa sepenuhnya memahami risiko-risiko tersebut sering kali mengalami kendala yang dapat diprediksi.

Dalam praktiknya, AI hanya berhasil jika alat, proses, dan keluaran konten membuat manusia tetap memegang kendali.