Katakanlah seseorang membawa Bulldog Prancisnya, Bowser, ke taman anjing. Mengidentifikasi Bowser saat ia bermain di antara gigi taring lainnya mudah dilakukan oleh pemilik anjing saat berada di lokasi.

Namun jika seseorang ingin menggunakan model AI generatif seperti GPT-5 untuk memantau hewan peliharaannya saat mereka sedang bekerja, model tersebut mungkin gagal dalam tugas dasar ini. Model bahasa penglihatan seperti GPT-5 sering kali unggul dalam mengenali objek umum, seperti anjing, namun performanya buruk dalam menemukan lokasi objek yang dipersonalisasi, seperti Bowser si Bulldog Prancis.

Untuk mengatasi kekurangan ini, para peneliti dari MIT dan MIT-IBM Watson AI Lab telah memperkenalkan metode pelatihan baru yang mengajarkan model bahasa penglihatan untuk melokalisasi objek yang dipersonalisasi dalam sebuah adegan.

Metode mereka menggunakan data pelacakan video yang dipersiapkan dengan cermat di mana objek yang sama dilacak di beberapa frame. Mereka merancang kumpulan data sehingga modelnya harus fokus pada petunjuk kontekstual untuk mengidentifikasi objek yang dipersonalisasi, daripada mengandalkan pengetahuan yang telah diingat sebelumnya.

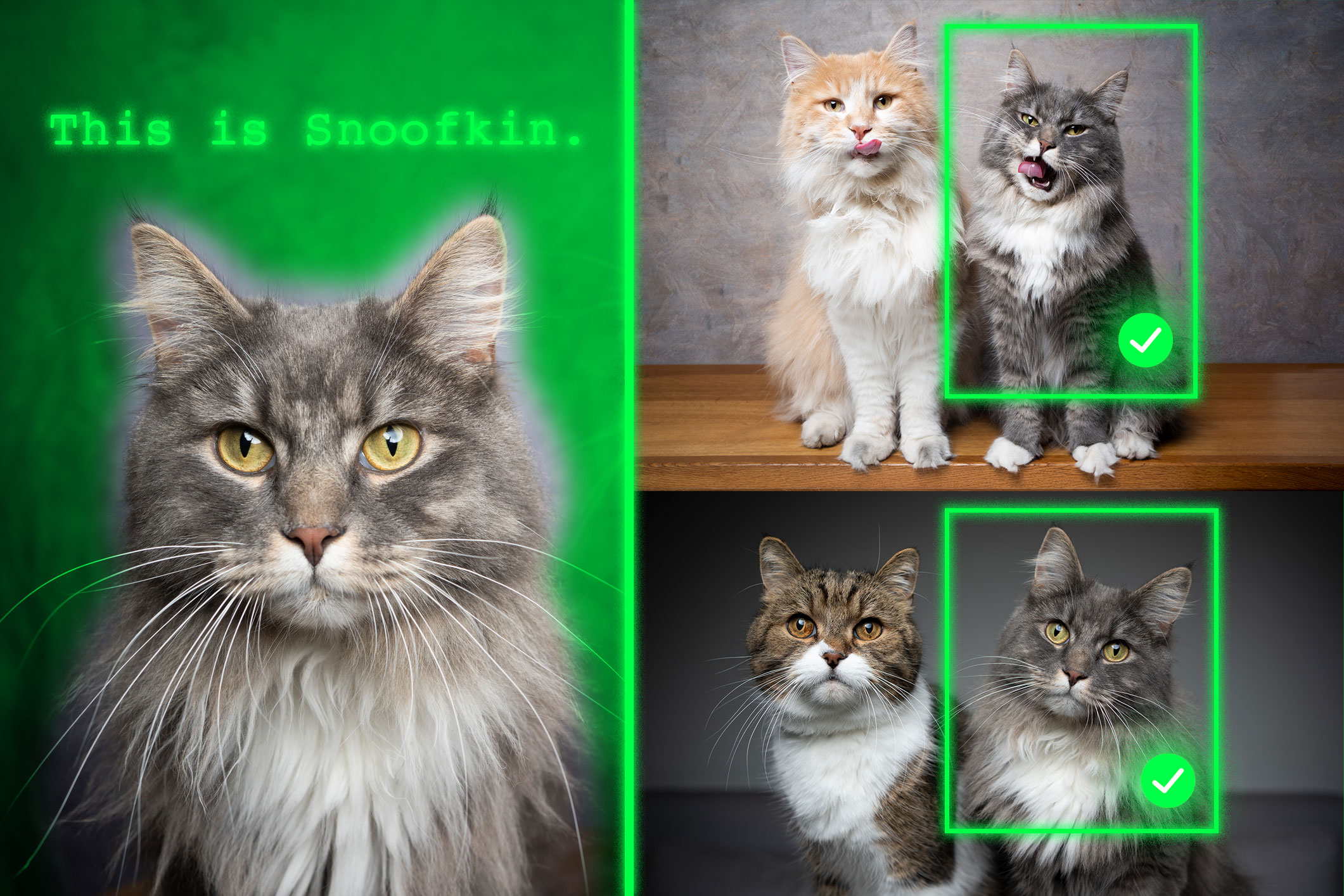

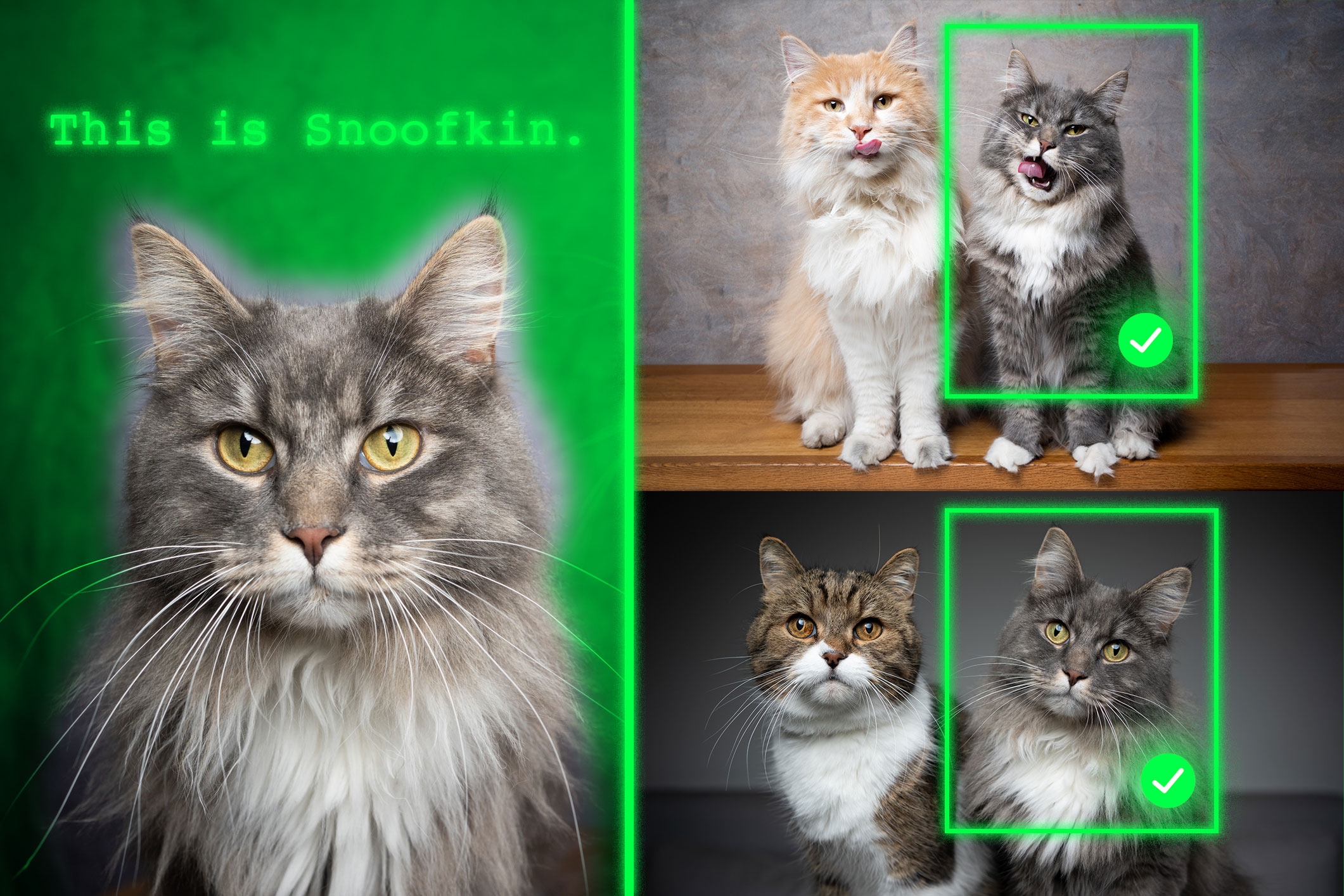

Saat diberikan beberapa contoh gambar yang menampilkan objek yang dipersonalisasi, seperti hewan peliharaan seseorang, model yang dilatih ulang akan lebih mampu mengidentifikasi lokasi hewan peliharaan yang sama di gambar baru.

Model yang dilatih ulang dengan metodenya mengungguli sistem canggih dalam tugas ini. Yang penting, teknik mereka menjaga kemampuan umum model lainnya tetap utuh.

Pendekatan baru ini dapat membantu sistem AI di masa depan melacak objek tertentu sepanjang waktu, seperti ransel anak-anak, atau melokalisasi objek menarik, seperti spesies hewan dalam pemantauan ekologi. Hal ini juga dapat membantu pengembangan teknologi bantu berbasis AI yang membantu pengguna tunanetra menemukan item tertentu di dalam ruangan.

“Pada akhirnya, kami ingin model-model ini dapat belajar dari konteks, sama seperti manusia. Jika sebuah model dapat melakukan hal ini dengan baik, daripada melatihnya kembali untuk setiap tugas baru, kami hanya dapat memberikan beberapa contoh dan model tersebut akan menyimpulkan cara melakukan tugas dari konteks tersebut. Ini adalah kemampuan yang sangat hebat,” kata Jehanzeb Mirza, seorang postdoc MIT dan penulis senior makalah tentang teknik ini.

Mirza bergabung dalam makalah ini dengan rekan penulis utama Sivan Doveh, seorang mahasiswa pascasarjana di Weizmann Institute of Science; dan Nimrod Shabtay, peneliti di IBM Research; James Glass, ilmuwan peneliti senior dan kepala Kelompok Sistem Bahasa Lisan di Laboratorium Ilmu Komputer dan Kecerdasan Buatan MIT (CSAIL); dan lainnya. Karya ini akan dipresentasikan pada Konferensi Internasional tentang Computer Vision.

Sebuah kekurangan yang tidak terduga

Para peneliti telah menemukan bahwa model bahasa besar (LLM) dapat unggul dalam pembelajaran dari konteks. Jika mereka memberi LLM beberapa contoh tugas, seperti soal penjumlahan, LLM dapat belajar menjawab soal penjumlahan baru berdasarkan konteks yang telah disediakan.

Model bahasa visi (VLM) pada dasarnya adalah sebuah LLM dengan komponen visual yang terhubung dengannya, sehingga para peneliti MIT mengira model tersebut akan mewarisi kemampuan pembelajaran dalam konteks LLM. Namun hal ini tidak terjadi.

“Komunitas riset belum bisa menemukan jawaban hitam-putih terhadap masalah khusus ini. Kemacetan bisa timbul dari fakta bahwa beberapa informasi visual hilang dalam proses penggabungan dua komponen, tapi kita tidak tahu,” kata Mirza.

Para peneliti berupaya meningkatkan kemampuan VLM untuk melakukan lokalisasi dalam konteks, yang melibatkan pencarian objek tertentu dalam gambar baru. Mereka fokus pada data yang digunakan untuk melatih kembali VLM yang ada untuk tugas baru, sebuah proses yang disebut fine-tuning.

Data fine-tuning tipikal dikumpulkan dari sumber acak dan menggambarkan koleksi objek sehari-hari. Satu gambar mungkin berisi mobil yang diparkir di jalan, sementara gambar lainnya berisi karangan bunga.

“Tidak ada koherensi nyata dalam data ini, sehingga model tidak pernah belajar mengenali objek yang sama dalam beberapa gambar,” katanya.

Untuk mengatasi masalah ini, para peneliti mengembangkan kumpulan data baru dengan mengumpulkan sampel dari data pelacakan video yang ada. Data tersebut berupa klip video yang memperlihatkan objek yang sama bergerak dalam suatu pemandangan, seperti seekor harimau yang berjalan melintasi padang rumput.

Mereka memotong bingkai dari video-video ini dan menyusun kumpulan data sehingga setiap masukan akan terdiri dari beberapa gambar yang menunjukkan objek yang sama dalam konteks berbeda, dengan contoh pertanyaan dan jawaban tentang lokasinya.

“Dengan menggunakan beberapa gambar dari objek yang sama dalam konteks berbeda, kami mendorong model untuk secara konsisten melokalisasi objek yang diinginkan dengan berfokus pada konteksnya,” jelas Mirza.

Memaksa fokus

Namun para peneliti menemukan bahwa VLM cenderung curang. Daripada menjawab berdasarkan petunjuk konteks, mereka akan mengidentifikasi objek menggunakan pengetahuan yang diperoleh selama pra-pelatihan.

Misalnya, karena model tersebut telah mengetahui bahwa gambar harimau dan label “harimau” saling berkorelasi, model ini dapat mengidentifikasi harimau yang melintasi padang rumput berdasarkan pengetahuan yang telah dilatih sebelumnya, dan bukan menyimpulkan berdasarkan konteks.

Untuk mengatasi masalah ini, para peneliti menggunakan nama palsu daripada nama kategori objek sebenarnya dalam kumpulan data. Dalam hal ini, mereka mengubah nama harimau tersebut menjadi “Charlie”.

“Kami memerlukan waktu cukup lama untuk mengetahui cara mencegah model melakukan kecurangan. Namun kami mengubah cara pandang model tersebut. Model tersebut tidak mengetahui bahwa ‘Charlie’ bisa jadi seekor macan, sehingga terpaksa melihat konteksnya,” ujarnya.

Para peneliti juga menghadapi tantangan dalam menemukan cara terbaik untuk menyiapkan data. Jika frame terlalu berdekatan, latar belakang tidak akan cukup berubah untuk memberikan keragaman data.

Pada akhirnya, menyempurnakan VLM dengan kumpulan data baru ini meningkatkan akurasi pada pelokalan yang dipersonalisasi rata-rata sekitar 12 persen. Ketika mereka memasukkan kumpulan data dengan nama samaran, peningkatan kinerja mencapai 21 persen.

Seiring bertambahnya ukuran model, tekniknya menghasilkan peningkatan performa yang lebih besar.

Di masa depan, para peneliti ingin mempelajari kemungkinan alasan VLM tidak mewarisi kemampuan pembelajaran dalam konteks dari LLM dasar mereka. Selain itu, mereka berencana untuk mengeksplorasi mekanisme tambahan untuk meningkatkan kinerja VLM tanpa perlu melatihnya kembali dengan data baru.

“Pekerjaan ini membingkai ulang pelokalan objek yang dipersonalisasi dalam beberapa pengambilan gambar – beradaptasi dengan cepat ke objek yang sama di seluruh adegan baru – sebagai masalah penyetelan instruksi dan menggunakan rangkaian pelacakan video untuk mengajari VLM melakukan pelokalan berdasarkan konteks visual, bukan berdasarkan kelas sebelumnya. Karya ini juga memperkenalkan tolok ukur pertama untuk pengaturan ini dengan peningkatan yang kuat di seluruh VLM terbuka dan berpemilik. Mengingat betapa pentingnya landasan yang cepat dan spesifik untuk instans – sering kali tanpa penyesuaian – bagi pengguna alur kerja dunia nyata (seperti robotika, asisten augmented reality, alat kreatif, dll.), resep praktis dan berpusat pada data yang ditawarkan oleh karya ini dapat membantu meningkatkan adopsi model dasar bahasa visi secara luas,” kata Saurav Jha, seorang postdoc di Mila-Quebec Artificial Intelligence Institute, yang tidak terlibat dalam pekerjaan ini.

Rekan penulis tambahan adalah Wei Lin, rekan peneliti di Universitas Johannes Kepler; Eli Schwartz, seorang ilmuwan peneliti di IBM Research; Hilde Kuehne, profesor ilmu komputer di Tuebingen AI Center dan profesor afiliasi di MIT-IBM Watson AI Lab; Raja Giryes, seorang profesor di Universitas Tel Aviv; Rogerio Feris, ilmuwan utama dan manajer di MIT-IBM Watson AI Lab; Leonid Karlinsky, ilmuwan peneliti utama di IBM Research; Assaf Arbelle, ilmuwan peneliti senior di IBM Research; dan Shimon Ullman, Profesor Ilmu Komputer Samy dan Ruth Cohn di Institut Sains Weizmann.

Penelitian ini sebagian didanai oleh MIT-IBM Watson AI Lab.