Model bahasa besar (LLM) seperti ChatGPT dapat menulis esai atau merencanakan menu hampir seketika. Namun hingga saat ini, mereka juga mudah bingung. Model tersebut, yang mengandalkan pola bahasa untuk merespons pertanyaan pengguna, sering kali gagal dalam soal matematika dan tidak bagus dalam penalaran yang rumit. Namun tiba-tiba, mereka menjadi jauh lebih baik dalam hal ini.

Generasi baru LLM yang dikenal sebagai model penalaran sedang dilatih untuk memecahkan masalah yang kompleks. Seperti halnya manusia, mereka memerlukan waktu untuk memikirkan masalah-masalah seperti ini – dan yang luar biasa, para ilmuwan di Institut Penelitian Otak McGovern di MIT telah menemukan bahwa jenis-jenis masalah yang memerlukan pemrosesan paling banyak dari model penalaran adalah masalah-masalah yang sama yang membutuhkan waktu untuk diselesaikan oleh manusia. Dengan kata lain, mereka melaporkan hari ini di jurnal PNAS“biaya berpikir” untuk model penalaran serupa dengan biaya berpikir manusia.

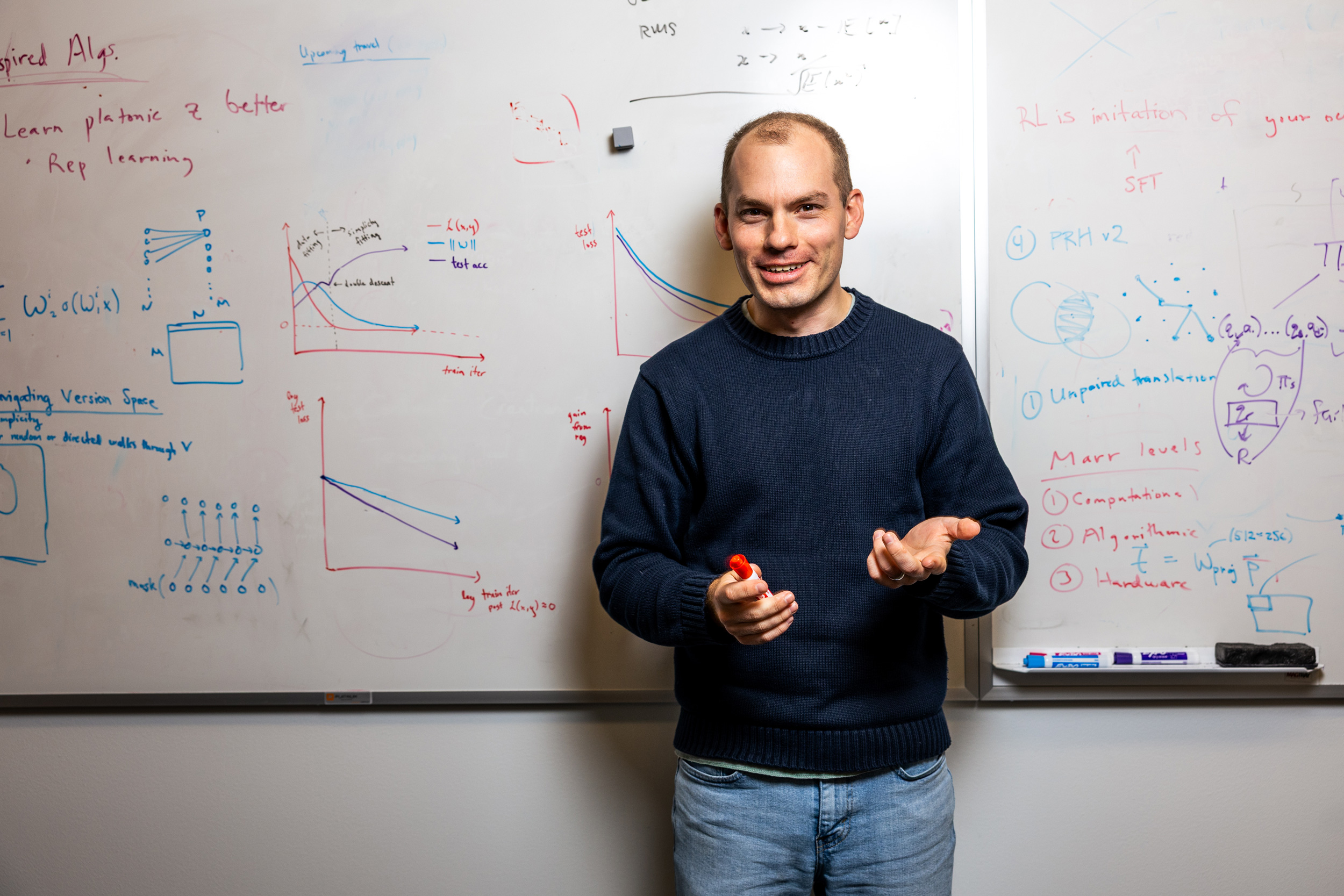

Para peneliti, yang dipimpin oleh Evelina Fedorenko, seorang profesor ilmu otak dan kognitif dan peneliti di McGovern Institute, menyimpulkan bahwa setidaknya dalam satu hal penting, model penalaran memiliki pendekatan berpikir yang mirip manusia. Menurut mereka, hal itu bukanlah sebuah rancangan. “Orang-orang yang membangun model ini tidak peduli apakah mereka melakukannya seperti manusia. Mereka hanya menginginkan sistem yang dapat bekerja dengan baik dalam segala kondisi dan menghasilkan respons yang tepat,” kata Fedorenko. “Fakta adanya konvergensi sungguh sangat mengejutkan.”

Model penalaran

Seperti banyak bentuk kecerdasan buatan, model penalaran baru adalah jaringan syaraf tiruan: alat komputasi yang mempelajari cara memproses informasi ketika mereka diberi data dan masalah untuk dipecahkan. Jaringan saraf tiruan telah sangat berhasil dalam banyak tugas yang dapat dilakukan dengan baik oleh jaringan saraf di otak sendiri — dan dalam beberapa kasus, para ilmuwan saraf telah menemukan bahwa jaringan saraf tiruan yang memiliki kinerja terbaik memiliki aspek-aspek tertentu dalam pemrosesan informasi di otak. Namun, beberapa ilmuwan berpendapat bahwa kecerdasan buatan belum siap untuk mengambil alih aspek kecerdasan manusia yang lebih canggih.

“Sampai baru-baru ini, saya adalah salah satu orang yang mengatakan, ‘Model-model ini sangat bagus dalam hal-hal seperti persepsi dan bahasa, namun masih banyak hal yang perlu dilakukan sampai kita memiliki model jaringan saraf yang dapat melakukan penalaran,” kata Fedorenko. “Kemudian model penalaran besar ini muncul dan mereka tampaknya melakukan banyak tugas berpikir dengan lebih baik, seperti memecahkan masalah matematika dan menulis kode komputer.”

Andrea Gregor de Varda, K. Lisa Yang ICoN Center Fellow dan mahasiswa pascadoktoral di lab Fedorenko, menjelaskan bahwa model penalaran menyelesaikan masalah langkah demi langkah. “Pada titik tertentu, orang-orang menyadari bahwa model memerlukan lebih banyak ruang untuk melakukan komputasi aktual yang diperlukan untuk memecahkan masalah kompleks,” katanya. “Performanya mulai menjadi jauh lebih kuat jika Anda membiarkan model memecah masalah menjadi beberapa bagian.”

Untuk mendorong model mengatasi masalah kompleks dalam langkah-langkah yang mengarah pada solusi yang tepat, insinyur dapat menggunakan pembelajaran penguatan. Selama pelatihan, model diberi imbalan atas jawaban yang benar dan diberi sanksi jika menjawab salah. “Model-model tersebut mengeksplorasi ruang masalahnya sendiri,” kata de Varda. “Tindakan yang mengarah pada imbalan positif diperkuat sehingga lebih sering menghasilkan solusi yang tepat.”

Model yang dilatih dengan cara ini jauh lebih mungkin menghasilkan jawaban yang sama dengan manusia ketika diberi tugas penalaran dibandingkan pendahulunya. Pemecahan masalah bertahap mereka berarti model penalaran membutuhkan waktu lebih lama untuk menemukan jawaban dibandingkan LLM yang ada sebelumnya — tetapi karena mereka mendapatkan jawaban yang benar meskipun model sebelumnya mungkin gagal, tanggapan mereka layak untuk ditunggu.

Kebutuhan para model untuk meluangkan waktu untuk mengatasi masalah yang kompleks sudah menunjukkan hal yang serupa dengan pemikiran manusia: jika Anda menuntut seseorang memecahkan masalah yang sulit secara instan, mereka mungkin akan gagal juga. De Varda ingin mengkaji hubungan ini secara lebih sistematis. Jadi dia memberikan serangkaian masalah yang sama kepada model penalaran dan sukarelawan, dan melacak tidak hanya apakah mereka mendapatkan jawaban yang benar, tetapi juga berapa banyak waktu atau upaya yang mereka perlukan untuk sampai ke sana.

Waktu versus token

Ini berarti mengukur berapa lama waktu yang dibutuhkan orang untuk merespons setiap pertanyaan, hingga hitungan milidetik. Untuk modelnya, Varda menggunakan metrik yang berbeda. Tidak masuk akal untuk mengukur waktu pemrosesan, karena hal ini lebih bergantung pada perangkat keras komputer daripada upaya yang dilakukan model untuk memecahkan masalah. Jadi, dia malah melacak token, yang merupakan bagian dari rantai pemikiran internal model. “Mereka menghasilkan token yang tidak dimaksudkan untuk dilihat dan dikerjakan oleh pengguna, tetapi hanya untuk melacak komputasi internal yang mereka lakukan,” jelas de Varda. “Sepertinya mereka sedang berbicara pada diri mereka sendiri.”

Baik manusia maupun model penalaran diminta untuk memecahkan tujuh jenis masalah berbeda, seperti aritmatika numerik dan penalaran intuitif. Untuk setiap kelas soal, mereka diberikan banyak soal. Semakin sulit suatu masalah, semakin lama waktu yang dibutuhkan orang untuk menyelesaikannya — dan semakin lama waktu yang dibutuhkan orang untuk menyelesaikan suatu masalah, semakin banyak token yang dihasilkan oleh model penalaran dalam menemukan solusinya.

Demikian pula, kelompok permasalahan yang membutuhkan waktu paling lama untuk dipecahkan oleh manusia adalah kelompok permasalahan yang sama yang memerlukan token paling banyak untuk modelnya: permasalahan aritmetika merupakan permasalahan yang paling sedikit tuntutannya, sedangkan kelompok permasalahan yang disebut “tantangan ARC,” dimana pasangan grid berwarna merepresentasikan transformasi yang harus disimpulkan dan kemudian diterapkan pada objek baru, merupakan permasalahan yang paling merugikan baik bagi manusia maupun model.

De Varda dan Fedorenko mengatakan kecocokan yang mencolok dalam biaya berpikir menunjukkan satu cara di mana model penalaran berpikir seperti manusia. Namun bukan berarti model tersebut menciptakan kembali kecerdasan manusia. Para peneliti masih ingin mengetahui apakah model tersebut menggunakan representasi informasi yang mirip dengan otak manusia, dan bagaimana representasi tersebut diubah menjadi solusi terhadap masalah. Mereka juga penasaran apakah model tersebut akan mampu menangani masalah yang memerlukan pengetahuan dunia yang tidak disebutkan dalam teks yang digunakan untuk pelatihan model.

Para peneliti menunjukkan bahwa meskipun model penalaran menghasilkan monolog internal ketika memecahkan masalah, model tersebut tidak selalu menggunakan bahasa untuk berpikir. “Jika Anda melihat keluaran yang dihasilkan oleh model-model ini saat melakukan penalaran, sering kali terdapat kesalahan atau beberapa bagian yang tidak masuk akal, meskipun model tersebut pada akhirnya menghasilkan jawaban yang benar. Jadi komputasi internal sebenarnya kemungkinan besar terjadi dalam ruang representasi abstrak dan non-linguistik, mirip dengan bagaimana manusia tidak menggunakan bahasa untuk berpikir,” katanya.