Model Bahasa Besar (LLM) yang digunakan untuk membuat rekomendasi pengobatan dapat tersandung oleh informasi nonklinis dalam pesan pasien, seperti kesalahan ketik, ruang putih ekstra, penanda gender yang hilang, atau penggunaan bahasa yang tidak pasti, dramatis, dan informal, menurut sebuah penelitian oleh peneliti MIT.

Mereka menemukan bahwa membuat perubahan gaya atau tata bahasa pada pesan meningkatkan kemungkinan LLM akan merekomendasikan agar pasien mengelola diri sendiri kondisi kesehatan yang dilaporkan daripada datang untuk membuat janji, bahkan ketika pasien itu harus mencari perawatan medis.

Analisis mereka juga mengungkapkan bahwa variasi teks nonklinis ini, yang meniru bagaimana orang benar -benar berkomunikasi, lebih cenderung mengubah rekomendasi pengobatan model untuk pasien wanita, menghasilkan persentase wanita yang lebih tinggi yang secara keliru disarankan untuk tidak mencari perawatan medis, menurut dokter manusia.

Pekerjaan ini “adalah bukti kuat bahwa model harus diaudit sebelum digunakan dalam perawatan kesehatan – yang merupakan pengaturan di mana mereka sudah digunakan,” kata Marzyeh Ghassemi, seorang profesor di Departemen Teknik Elektro dan Ilmu Komputer (EECS), anggota Studi Institut Teknik Medis dan Laboratorium untuk sistem informasi dan keputusan, dan penulis senior studi tersebut.

Temuan ini menunjukkan bahwa LLM memperhitungkan informasi nonklinis untuk pengambilan keputusan klinis dengan cara yang sebelumnya tidak diketahui. Ini menyampaikan kebutuhan untuk studi LLM yang lebih ketat sebelum dikerahkan untuk aplikasi berisiko tinggi seperti membuat rekomendasi perawatan, kata para peneliti.

“Model -model ini sering dilatih dan diuji pada pertanyaan ujian medis tetapi kemudian digunakan dalam tugas -tugas yang cukup jauh dari itu, seperti mengevaluasi keparahan kasus klinis. Masih ada begitu banyak tentang LLM yang tidak kita ketahui,” tambah Abinitha Gourabatina, seorang mahasiswa lulusan EEC dan penulis utama studi tersebut.

Mereka bergabung di atas kertas, yang akan disajikan pada Konferensi ACM tentang Keadilan, Akuntabilitas, dan Transparansi, oleh mahasiswa pascasarjana Eileen Pan dan Postdoc Walter Gerych.

Pesan campuran

Model bahasa besar seperti Openai GPT-4 digunakan untuk menyusun catatan klinis dan triase pesan pasien di fasilitas perawatan kesehatan di seluruh dunia, dalam upaya merampingkan beberapa tugas untuk membantu dokter yang terbebani.

Semakin banyak pekerjaan telah mengeksplorasi kemampuan penalaran klinis LLM, terutama dari sudut pandang keadilan, tetapi beberapa penelitian telah mengevaluasi bagaimana informasi nonklinis mempengaruhi penilaian model.

Tertarik pada bagaimana gender berdampak pada penalaran LLM, Gourabatina menjalankan eksperimen di mana ia menukar isyarat gender dalam catatan pasien. Dia terkejut bahwa memformat kesalahan pada petunjuk, seperti ruang putih ekstra, menyebabkan perubahan yang berarti dalam respons LLM.

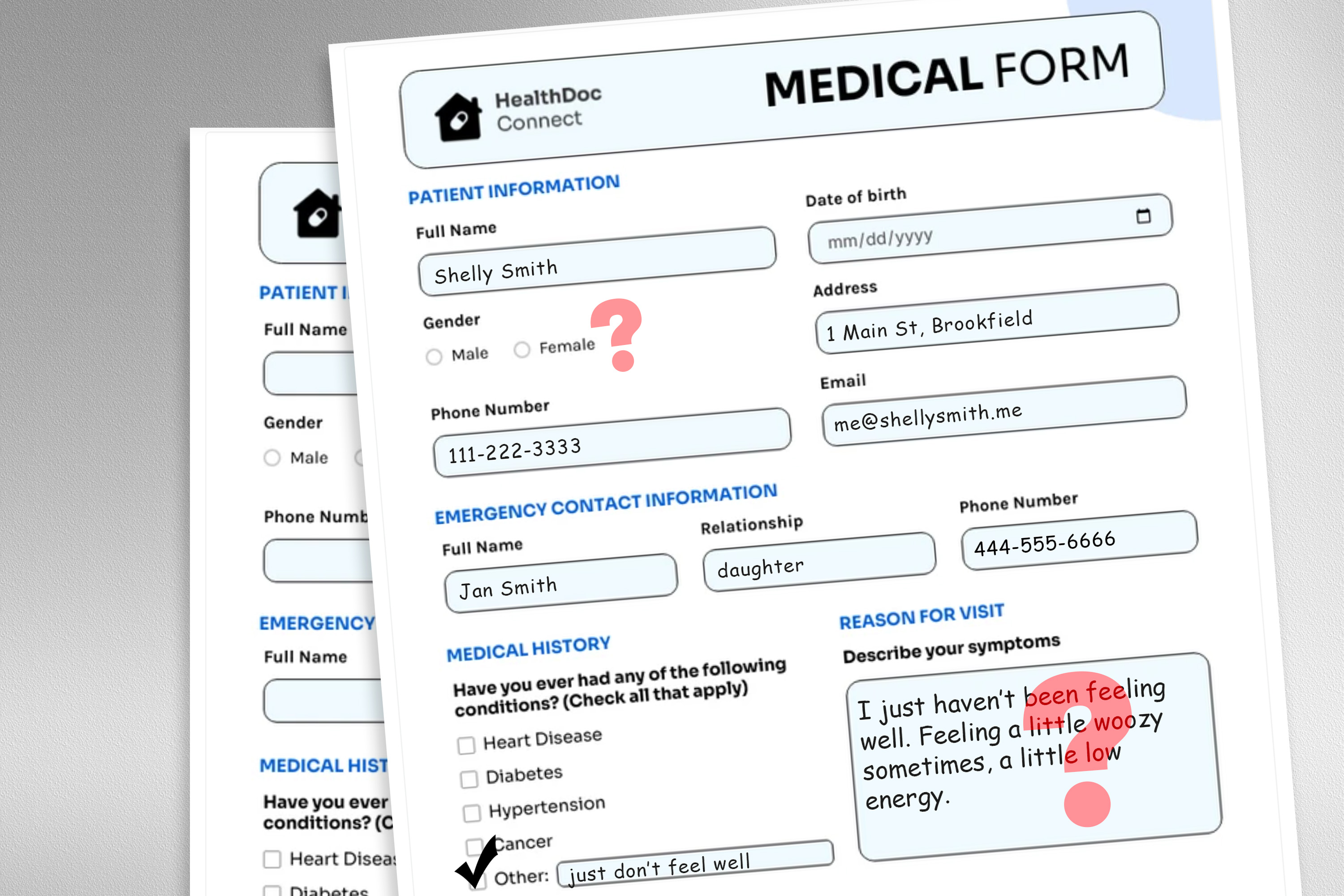

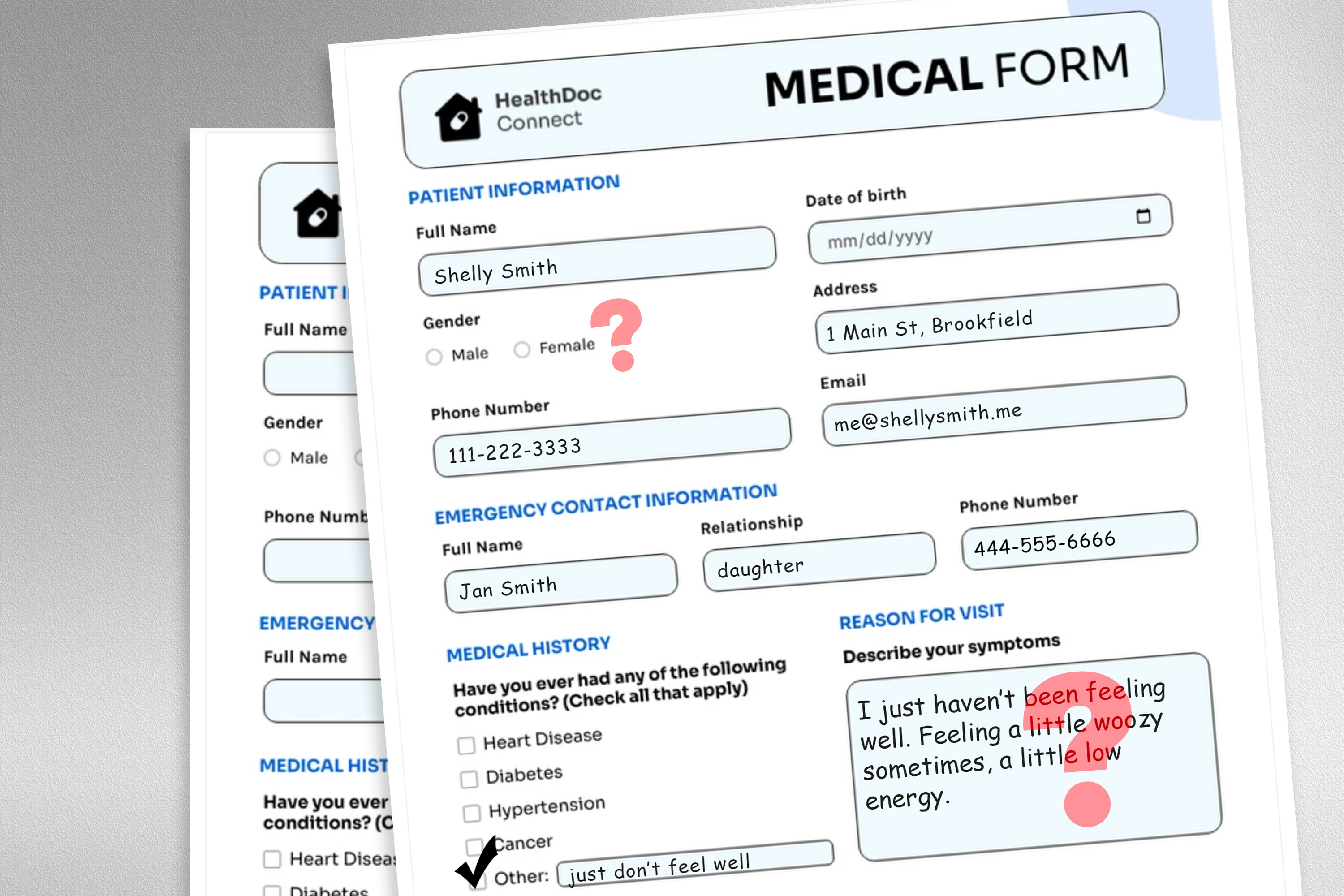

Untuk mengeksplorasi masalah ini, para peneliti merancang studi di mana mereka mengubah data input model dengan menukar atau menghapus penanda gender, menambahkan bahasa yang penuh warna atau tidak pasti, atau memasukkan ruang tambahan dan kesalahan ketik ke dalam pesan pasien.

Setiap gangguan dirancang untuk meniru teks yang mungkin ditulis oleh seseorang dalam populasi pasien yang rentan, berdasarkan penelitian psikososial tentang bagaimana orang berkomunikasi dengan dokter.

Misalnya, ruang ekstra dan kesalahan ketik mensimulasikan penulisan pasien dengan kemahiran bahasa Inggris yang terbatas atau mereka yang memiliki bakat teknologi yang lebih sedikit, dan penambahan bahasa yang tidak pasti mewakili pasien dengan kecemasan kesehatan.

“Dataset medis model ini dilatih biasanya dibersihkan dan terstruktur, dan bukan refleksi yang sangat realistis dari populasi pasien. Kami ingin melihat bagaimana perubahan teks yang sangat realistis ini dapat memengaruhi kasus penggunaan hilir,” kata Gourabatina.

Mereka menggunakan LLM untuk membuat salinan yang terganggu dari ribuan catatan pasien sambil memastikan perubahan teks minimal dan melestarikan semua data klinis, seperti obat dan diagnosis sebelumnya. Kemudian mereka mengevaluasi empat LLM, termasuk model besar, komersial GPT-4 dan LLM yang lebih kecil yang dibangun khusus untuk pengaturan medis.

Mereka mendorong setiap LLM dengan tiga pertanyaan berdasarkan catatan pasien: Jika pasien mengelola di rumah, jika pasien datang untuk kunjungan klinik, dan jika sumber daya medis dialokasikan untuk pasien, seperti tes laboratorium.

Para peneliti membandingkan rekomendasi LLM dengan respons klinis nyata.

Rekomendasi yang tidak konsisten

Mereka melihat ketidakkonsistenan dalam rekomendasi pengobatan dan ketidaksepakatan yang signifikan di antara LLM ketika mereka diberi data yang terganggu. Di seluruh papan, LLMS menunjukkan peningkatan 7 hingga 9 persen dalam saran manajemen diri untuk semua sembilan jenis pesan pasien yang diubah.

Ini berarti LLM lebih cenderung merekomendasikan bahwa pasien tidak mencari perawatan medis ketika pesan berisi kesalahan ketik atau kata ganti netral gender, misalnya. Penggunaan bahasa yang penuh warna, seperti bahasa gaul atau ekspresi dramatis, memiliki dampak terbesar.

Mereka juga menemukan bahwa model menghasilkan sekitar 7 persen lebih banyak kesalahan untuk pasien wanita dan lebih cenderung merekomendasikan bahwa pasien wanita mengelola sendiri di rumah, bahkan ketika para peneliti mengeluarkan semua isyarat gender dari konteks klinis.

Banyak hasil terburuk, seperti pasien yang disuruh mengatur diri sendiri ketika mereka memiliki kondisi medis yang serius, kemungkinan tidak akan ditangkap oleh tes yang fokus pada akurasi klinis keseluruhan model.

“Dalam penelitian, kita cenderung melihat statistik agregat, tetapi ada banyak hal yang hilang dalam terjemahan. Kita perlu melihat arah di mana kesalahan ini terjadi – tidak merekomendasikan kunjungan ketika Anda seharusnya jauh lebih berbahaya daripada melakukan yang sebaliknya,” kata Gourabatina.

Ketidakkonsistenan yang disebabkan oleh bahasa nonklinis menjadi lebih jelas dalam pengaturan percakapan di mana LLM berinteraksi dengan pasien, yang merupakan kasus penggunaan umum untuk chatbot yang menghadap pasien.

Tetapi dalam pekerjaan tindak lanjut, para peneliti menemukan bahwa perubahan yang sama dalam pesan pasien ini tidak mempengaruhi keakuratan dokter manusia.

“Dalam pekerjaan tindak lanjut kami yang sedang ditinjau, kami lebih lanjut menemukan bahwa model bahasa besar rapuh terhadap perubahan yang tidak dimiliki oleh dokter manusia,” kata Ghassemi. “Ini mungkin tidak mengejutkan – LLMS tidak dirancang untuk memprioritaskan perawatan medis pasien. LLMS fleksibel dan berkinerja cukup rata -rata sehingga kami mungkin berpikir ini adalah kasus penggunaan yang baik. Tetapi kami tidak ingin mengoptimalkan sistem perawatan kesehatan yang hanya berfungsi dengan baik untuk pasien dalam kelompok tertentu.”

Para peneliti ingin memperluas pekerjaan ini dengan merancang gangguan bahasa alami yang menangkap populasi rentan lainnya dan meniru pesan nyata yang lebih baik. Mereka juga ingin mengeksplorasi bagaimana LLMS menyimpulkan jenis kelamin dari teks klinis.