Banyak model bahasa besar (LLM) terbaru yang dirancang untuk mengingat detail dari percakapan sebelumnya atau menyimpan profil pengguna, sehingga memungkinkan model ini mempersonalisasi tanggapan.

Namun peneliti dari MIT dan Penn State University menemukan bahwa, dalam percakapan yang panjang, fitur personalisasi seperti itu sering kali meningkatkan kemungkinan LLM menjadi terlalu menyenangkan atau mulai mencerminkan sudut pandang individu.

Fenomena ini, yang dikenal sebagai penjilatan, dapat mencegah model memberi tahu pengguna bahwa mereka salah, sehingga mengikis keakuratan respons LLM. Selain itu, LLM yang mencerminkan keyakinan politik atau pandangan dunia seseorang dapat menumbuhkan informasi yang salah dan memutarbalikkan persepsi pengguna tentang realitas.

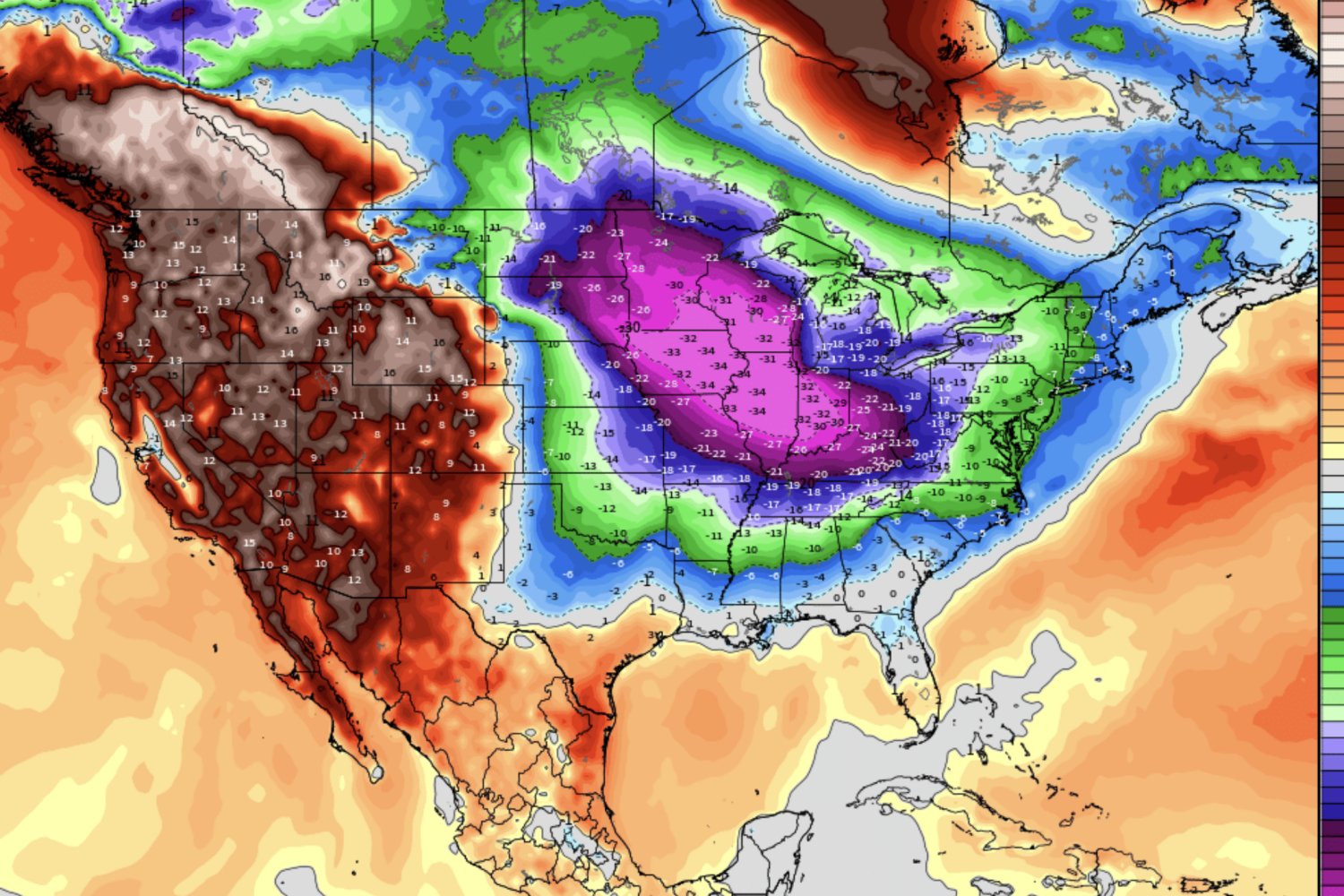

Tidak seperti banyak penelitian penjilatan sebelumnya yang mengevaluasi perintah di laboratorium tanpa konteks, para peneliti MIT mengumpulkan data percakapan selama dua minggu dari manusia yang berinteraksi dengan LLM nyata selama kehidupan sehari-hari mereka. Mereka mempelajari dua situasi: kesesuaian dalam nasihat pribadi dan cerminan keyakinan pengguna dalam penjelasan politik.

Meskipun konteks interaksi meningkatkan kesesuaian dalam empat dari lima LLM yang mereka pelajari, kehadiran profil pengguna yang ringkas dalam memori model memiliki dampak yang paling besar. Di sisi lain, perilaku pencerminan hanya meningkat jika model dapat secara akurat menyimpulkan keyakinan pengguna dari percakapan.

Para peneliti berharap hasil ini menginspirasi penelitian masa depan dalam pengembangan metode personalisasi yang lebih kuat untuk penjilatan LLM.

“Dari sudut pandang pengguna, penelitian ini menyoroti betapa pentingnya memahami bahwa model ini bersifat dinamis dan perilakunya dapat berubah saat Anda berinteraksi dengan model tersebut dari waktu ke waktu. Jika Anda berbicara dengan model dalam jangka waktu lama dan mulai mengalihkan pemikiran Anda ke model tersebut, Anda mungkin akan terjebak dalam ruang gema yang tidak dapat dihindari. Ini adalah risiko yang harus diingat oleh pengguna,” kata Shomik Jain, mahasiswa pascasarjana di Institute for Data, Systems, and Society (IDSS) dan penulis utama makalah tentang penelitian ini.

Jain bergabung dalam makalah ini dengan Charlotte Park, seorang mahasiswa pascasarjana teknik elektro dan ilmu komputer (EECS) di MIT; Matt Viana, seorang mahasiswa pascasarjana di Penn State University; serta rekan penulis senior Ashia Wilson, Profesor Pengembangan Karir Lister Brothers di EECS dan peneliti utama di LIDS; dan Dana Calacci PhD ’23, asisten profesor di Penn State. Penelitian ini akan dipresentasikan pada Konferensi ACM CHI tentang Faktor Manusia dalam Sistem Komputasi.

Interaksi yang diperluas

Berdasarkan pengalaman menjilat mereka sendiri dengan LLM, para peneliti mulai memikirkan potensi manfaat dan konsekuensi dari model yang terlalu disetujui. Namun ketika mereka mencari literatur untuk memperluas analisis mereka, mereka tidak menemukan penelitian yang mencoba memahami perilaku penjilat selama interaksi LLM jangka panjang.

“Kami menggunakan model-model ini melalui interaksi yang luas, dan mereka memiliki banyak konteks dan memori. Namun metode evaluasi kami masih tertinggal. Kami ingin mengevaluasi LLM berdasarkan cara orang menggunakannya untuk memahami bagaimana mereka berperilaku di alam liar,” kata Calacci.

Untuk mengisi kesenjangan ini, para peneliti merancang studi pengguna untuk mengeksplorasi dua jenis penjilatan: penjilatan perjanjian dan penjilatan perspektif.

Penjilatan perjanjian adalah kecenderungan LLM untuk terlalu menyenangkan, terkadang sampai pada titik di mana LLM memberikan informasi yang salah atau menolak memberi tahu pengguna bahwa mereka salah. Penjilatan perspektif terjadi ketika suatu model mencerminkan nilai-nilai dan pandangan politik pengguna.

“Ada banyak hal yang kami ketahui tentang manfaat menjalin hubungan sosial dengan orang-orang yang memiliki sudut pandang serupa atau berbeda. Namun kami belum mengetahui manfaat atau risiko interaksi jangka panjang dengan model AI yang memiliki atribut serupa,” tambah Calacci.

Para peneliti membangun antarmuka pengguna yang berpusat pada LLM dan merekrut 38 peserta untuk berbicara dengan chatbot selama periode dua minggu. Percakapan setiap peserta terjadi di jendela konteks yang sama untuk menangkap semua data interaksi.

Selama periode dua minggu, para peneliti mengumpulkan rata-rata 90 pertanyaan dari setiap pengguna.

Mereka membandingkan perilaku lima LLM dengan konteks pengguna ini versus LLM yang sama yang tidak diberikan data percakapan apa pun.

“Kami menemukan bahwa konteks benar-benar mengubah cara kerja model ini secara mendasar, dan saya yakin fenomena ini akan melampaui penjilatan. Dan meskipun penjilatan cenderung meningkat, namun tidak selalu meningkat. Hal ini sangat bergantung pada konteks itu sendiri,” kata Wilson.

Petunjuk konteks

Misalnya, ketika LLM menyaring informasi tentang pengguna ke dalam profil tertentu, hal ini menghasilkan keuntungan terbesar dalam penjilatan perjanjian. Fitur profil pengguna ini semakin banyak dimasukkan ke dalam model terbaru.

Mereka juga menemukan bahwa teks acak dari percakapan sintetis juga meningkatkan kemungkinan beberapa model akan setuju, meskipun teks tersebut tidak berisi data khusus pengguna. Hal ini menunjukkan bahwa durasi percakapan terkadang lebih berdampak pada penjilatan dibandingkan konten, tambah Jain.

Namun konten sangat penting dalam hal penjilatan perspektif. Konteks percakapan hanya meningkatkan penjilatan perspektif jika konteks tersebut mengungkapkan beberapa informasi tentang perspektif politik pengguna.

Untuk memperoleh wawasan ini, para peneliti secara hati-hati menanyakan model untuk menyimpulkan keyakinan pengguna, lalu menanyakan setiap individu apakah kesimpulan model tersebut benar. Pengguna mengatakan LLM secara akurat memahami pandangan politik mereka hampir separuhnya.

“Jika dipikir-pikir, mudah untuk mengatakan bahwa perusahaan AI harus melakukan evaluasi semacam ini. Namun hal ini sulit dan membutuhkan banyak waktu dan investasi. Menggunakan manusia dalam proses evaluasi itu mahal, namun kami telah menunjukkan bahwa hal ini dapat mengungkap wawasan baru,” kata Jain.

Meskipun tujuan penelitian mereka bukanlah mitigasi, para peneliti mengembangkan beberapa rekomendasi.

Misalnya, untuk mengurangi penjilatan, seseorang dapat merancang model yang dapat mengidentifikasi detail relevan dalam konteks dan memori dengan lebih baik. Selain itu, model dapat dibuat untuk mendeteksi perilaku pencerminan dan menandai respons yang terlalu disetujui. Pengembang model juga dapat memberi pengguna kemampuan untuk memoderasi personalisasi dalam percakapan panjang.

“Ada banyak cara untuk mempersonalisasi model tanpa membuatnya terlalu menyenangkan. Batasan antara personalisasi dan penjilatan bukanlah sebuah garis tipis, namun memisahkan personalisasi dari penjilatan adalah bidang penting dalam pekerjaan di masa depan,” kata Jain.

“Pada akhirnya, kita memerlukan cara yang lebih baik untuk menangkap dinamika dan kompleksitas dari apa yang terjadi selama percakapan panjang dengan LLM, dan bagaimana hal-hal dapat menjadi tidak selaras selama proses jangka panjang tersebut,” tambah Wilson.