Saat ini, ChatGPT, Claude, dan model bahasa besar lainnya telah mengumpulkan begitu banyak pengetahuan manusia sehingga mereka jauh dari penghasil jawaban yang sederhana; mereka juga dapat mengekspresikan konsep-konsep abstrak, seperti nada, kepribadian, bias, dan suasana hati tertentu. Namun, tidak jelas bagaimana model ini merepresentasikan konsep abstrak berdasarkan pengetahuan yang dikandungnya.

Kini tim dari MIT dan Universitas California San Diego telah mengembangkan cara untuk menguji apakah model bahasa besar (LLM) mengandung bias, kepribadian, suasana hati, atau konsep abstrak lainnya yang tersembunyi. Metode mereka dapat memusatkan perhatian pada koneksi dalam model yang mengkodekan konsep yang diminati. Terlebih lagi, metode tersebut kemudian dapat memanipulasi, atau “mengarahkan” hubungan-hubungan ini, untuk memperkuat atau melemahkan konsep dalam jawaban apa pun yang diminta untuk diberikan oleh model.

Tim ini membuktikan metode mereka dapat dengan cepat membasmi dan mengarahkan lebih dari 500 konsep umum di beberapa LLM terbesar yang digunakan saat ini. Misalnya, para peneliti dapat memahami representasi model untuk kepribadian seperti “influencer sosial” dan “ahli teori konspirasi,” dan sikap seperti “takut akan pernikahan” dan “penggemar Boston.” Mereka kemudian dapat menyesuaikan representasi ini untuk meningkatkan atau meminimalkan konsep dalam setiap jawaban yang dihasilkan model.

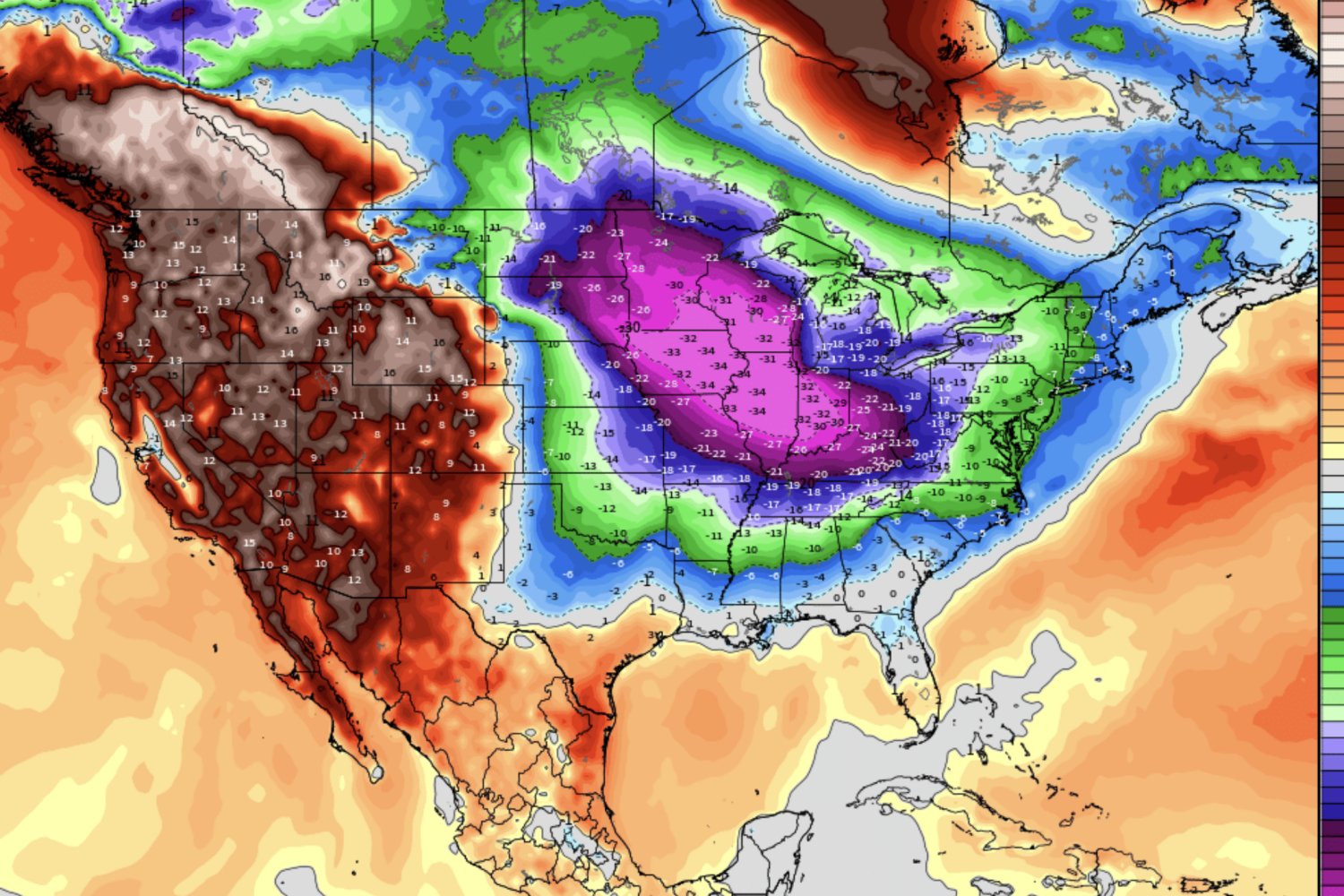

Dalam kasus konsep “ahli teori konspirasi”, tim berhasil mengidentifikasi representasi konsep ini dalam salah satu model bahasa visi terbesar yang tersedia saat ini. Ketika mereka menyempurnakan representasi tersebut, dan kemudian mendorong model tersebut untuk menjelaskan asal usul gambar Bumi “Marmer Biru” yang terkenal yang diambil dari Apollo 17, model tersebut menghasilkan jawaban dengan nada dan perspektif seorang ahli teori konspirasi.

Tim mengakui ada risiko dalam mengekstraksi konsep-konsep tertentu, yang juga mereka ilustrasikan (dan waspadai). Namun secara keseluruhan, mereka melihat pendekatan baru ini sebagai cara untuk menjelaskan konsep tersembunyi dan potensi kerentanan dalam LLM, yang kemudian dapat ditingkatkan atau diturunkan untuk meningkatkan keamanan model atau meningkatkan kinerjanya.

“Apa yang sebenarnya dikatakan tentang LLM adalah bahwa mereka memiliki konsep-konsep ini di dalamnya, namun tidak semuanya diekspos secara aktif,” kata Adityanarayanan “Adit” Radhakrishnan, asisten profesor matematika di MIT. “Dengan metode kami, ada cara untuk mengekstrak konsep-konsep yang berbeda ini dan mengaktifkannya dengan cara yang tidak dapat dijawab oleh dorongan.”

Tim mempublikasikan temuan mereka hari ini dalam sebuah penelitian yang muncul di jurnal Sains. Rekan penulis studi ini termasuk Radhakrishnan, Daniel Beaglehole dan Mikhail Belkin dari UC San Diego, dan Enric Boix-Adserà dari University of Pennsylvania.

Seekor ikan di dalam kotak hitam

Ketika penggunaan ChatGPT OpenAI, Gemini dari Google, Claude dari Anthropic, dan asisten kecerdasan buatan lainnya semakin meningkat, para ilmuwan berlomba untuk memahami bagaimana model mewakili konsep abstrak tertentu seperti “halusinasi” dan “penipuan.” Dalam konteks LLM, halusinasi adalah respons yang salah atau berisi informasi yang menyesatkan, yang telah “dihalusinasi” oleh model, atau dikonstruksikan secara keliru sebagai fakta.

Untuk mengetahui apakah konsep seperti “halusinasi” dikodekan dalam LLM, para ilmuwan sering kali mengambil pendekatan “pembelajaran tanpa pengawasan” – sejenis pembelajaran mesin di mana algoritma secara luas menelusuri representasi tanpa label untuk menemukan pola yang mungkin berhubungan dengan konsep seperti “halusinasi.” Namun bagi Radhakrishnan, pendekatan seperti itu mungkin terlalu luas dan mahal secara komputasi.

“Ini seperti memancing dengan jaring besar, mencoba menangkap satu spesies ikan. Anda akan mendapatkan banyak ikan yang harus Anda teliti untuk menemukan ikan yang tepat,” katanya. “Sebaliknya, kami menggunakan umpan untuk spesies ikan yang tepat.”

Dia dan rekan-rekannya sebelumnya telah mengembangkan pendekatan yang lebih bertarget dengan jenis algoritma pemodelan prediktif yang dikenal sebagai mesin fitur rekursif (RFM). RFM dirancang untuk secara langsung mengidentifikasi fitur atau pola dalam data dengan memanfaatkan mekanisme matematis yang digunakan jaringan saraf — kategori luas model AI yang mencakup LLM — untuk mempelajari fitur.

Karena algoritme merupakan pendekatan yang efektif dan efisien untuk menangkap fitur secara umum, tim bertanya-tanya apakah mereka dapat menggunakannya untuk membasmi representasi konsep, dalam LLM, yang sejauh ini merupakan jenis jaringan saraf yang paling banyak digunakan dan mungkin paling sedikit dipahami dengan baik.

“Kami ingin menerapkan algoritme pembelajaran fitur kami ke LLM untuk, dengan cara yang ditargetkan, menemukan representasi konsep dalam model yang besar dan kompleks ini,” kata Radhakrishnan.

Menyatu pada sebuah konsep

Pendekatan baru tim ini mengidentifikasi konsep apa pun yang diminati dalam LLM dan “mengarahkan” atau memandu respons model berdasarkan konsep ini. Para peneliti mencari 512 konsep dalam lima kelas: ketakutan (seperti pernikahan, serangga, dan bahkan kancing); para ahli (influencer sosial, ahli abad pertengahan); suasana hati (sombong, geli); preferensi lokasi (Boston, Kuala Lumpur); dan persona (Ada Lovelace, Neil deGrasse Tyson).

Para peneliti kemudian mencari representasi setiap konsep dalam beberapa model bahasa dan visi besar saat ini. Mereka melakukannya dengan melatih RFM untuk mengenali pola numerik dalam LLM yang dapat mewakili konsep minat tertentu.

Model bahasa besar standar, secara umum, adalah jaringan saraf yang menggunakan perintah bahasa alami, seperti “Mengapa langit berwarna biru?” dan membagi prompt menjadi kata-kata individual, yang masing-masing dikodekan secara matematis sebagai daftar, atau vektor, angka. Model ini mengambil vektor-vektor ini melalui serangkaian lapisan komputasi, menciptakan matriks dengan banyak angka yang, di setiap lapisan, digunakan untuk mengidentifikasi kata-kata lain yang paling mungkin digunakan untuk merespons perintah awal. Pada akhirnya, lapisan-lapisan tersebut berkumpul pada sekumpulan angka yang diterjemahkan kembali menjadi teks, dalam bentuk respons bahasa alami.

Pendekatan tim melatih RFM untuk mengenali pola numerik dalam LLM yang dapat dikaitkan dengan konsep tertentu. Sebagai contoh, untuk melihat apakah LLM berisi representasi dari “ahli teori konspirasi,” para peneliti pertama-tama akan melatih algoritma untuk mengidentifikasi pola di antara representasi LLM dari 100 petunjuk yang jelas terkait dengan konspirasi, dan 100 petunjuk lainnya yang tidak. Dengan cara ini, algoritme akan mempelajari pola yang terkait dengan konsep teori konspirasi. Kemudian, para peneliti dapat memodulasi aktivitas konsep teori konspirasi secara matematis dengan mengganggu representasi LLM dengan pola yang teridentifikasi ini.

Metode ini dapat diterapkan untuk mencari dan memanipulasi konsep umum apa pun dalam sebuah LLM. Di antara banyak contoh, para peneliti mengidentifikasi representasi dan memanipulasi LLM untuk memberikan jawaban dalam nada dan perspektif “ahli teori konspirasi.” Mereka juga mengidentifikasi dan menyempurnakan konsep “anti-penolakan,” dan menunjukkan bahwa biasanya sebuah model diprogram untuk menolak perintah tertentu, namun model tersebut menjawab, misalnya memberikan instruksi tentang cara merampok bank.

Radhakrishnan mengatakan pendekatan ini dapat digunakan untuk mencari dan meminimalkan kerentanan di LLM dengan cepat. Hal ini juga dapat digunakan untuk meningkatkan sifat, kepribadian, suasana hati, atau preferensi tertentu, seperti menekankan konsep “singkatnya” atau “penalaran” dalam respons apa pun yang dihasilkan LLM. Tim telah membuat kode dasar metode ini tersedia untuk umum.

“LLM jelas memiliki banyak konsep abstrak yang tersimpan di dalamnya, dalam beberapa representasi,” kata Radhakrishnan. “Ada cara dimana, jika kita memahami representasi ini dengan cukup baik, kita dapat membangun LLM yang sangat terspesialisasi yang masih aman untuk digunakan namun sangat efektif pada tugas-tugas tertentu.”

Pekerjaan ini sebagian didukung oleh National Science Foundation, Simons Foundation, TILOS Institute, dan US Office of Naval Research.