Perusahaan yang ingin menggunakan model bahasa besar (LLM) untuk merangkum laporan penjualan atau melakukan triase pertanyaan pelanggan dapat memilih di antara ratusan LLM unik dengan lusinan variasi model, masing-masing dengan kinerja yang sedikit berbeda.

Untuk mempersempit pilihan, perusahaan sering kali mengandalkan platform pemeringkatan LLM, yang mengumpulkan umpan balik pengguna tentang interaksi model untuk menentukan peringkat LLM terbaru berdasarkan kinerja mereka pada tugas tertentu.

Namun peneliti MIT menemukan bahwa beberapa interaksi pengguna dapat mengubah hasil, menyebabkan seseorang secara keliru percaya bahwa satu LLM adalah pilihan ideal untuk kasus penggunaan tertentu. Studi mereka mengungkapkan bahwa menghapus sebagian kecil data crowdsourcing dapat mengubah model mana yang berada di peringkat teratas.

Mereka mengembangkan metode cepat untuk menguji platform pemeringkatan dan menentukan apakah mereka rentan terhadap masalah ini. Teknik evaluasi mengidentifikasi suara individu yang paling bertanggung jawab atas distorsi hasil sehingga pengguna dapat memeriksa suara yang berpengaruh tersebut.

Para peneliti mengatakan penelitian ini menggarisbawahi perlunya strategi yang lebih ketat untuk mengevaluasi peringkat model. Meskipun mereka tidak fokus pada mitigasi dalam penelitian ini, mereka memberikan saran yang dapat meningkatkan ketahanan platform ini, seperti mengumpulkan masukan yang lebih rinci untuk membuat pemeringkatan.

Studi ini juga memberikan peringatan kepada pengguna yang mungkin mengandalkan peringkat ketika membuat keputusan tentang LLM yang dapat berdampak luas dan mahal pada bisnis atau organisasi.

“Kami terkejut bahwa platform pemeringkatan ini sangat sensitif terhadap masalah ini. Jika ternyata LLM peringkat teratas hanya bergantung pada dua atau tiga masukan pengguna dari puluhan ribu, maka kita tidak dapat berasumsi bahwa LLM peringkat teratas akan secara konsisten mengungguli semua LLM lainnya ketika diterapkan,” kata Tamara Broderick, seorang profesor di Departemen Teknik Elektro dan Ilmu Komputer (EECS) MIT; anggota Laboratorium Sistem Informasi dan Keputusan (LIDS) dan Institut Data, Sistem, dan Masyarakat; afiliasi dari Laboratorium Ilmu Komputer dan Kecerdasan Buatan (CSAIL); dan penulis senior penelitian ini.

Dia bergabung dalam makalah ini dengan penulis utama dan mahasiswa pascasarjana EECS Jenny Huang dan Yunyi Shen serta Dennis Wei, seorang ilmuwan peneliti senior di IBM Research. Studi ini akan dipresentasikan pada Konferensi Internasional tentang Representasi Pembelajaran.

Menjatuhkan data

Meskipun ada banyak jenis platform pemeringkatan LLM, variasi yang paling populer meminta pengguna untuk mengirimkan kueri ke dua model dan memilih LLM mana yang memberikan respons lebih baik.

Platform mengumpulkan hasil pertarungan ini untuk menghasilkan peringkat yang menunjukkan LLM mana yang berkinerja terbaik pada tugas tertentu, seperti pengkodean atau pemahaman visual.

Dengan memilih LLM yang berkinerja terbaik, pengguna kemungkinan besar mengharapkan peringkat teratas model tersebut untuk digeneralisasikan, artinya model tersebut harus mengungguli model lain pada aplikasi serupa, namun tidak identik, dengan serangkaian data baru.

Para peneliti MIT sebelumnya mempelajari generalisasi di berbagai bidang seperti statistik dan ekonomi. Penelitian tersebut mengungkapkan kasus-kasus tertentu di mana hilangnya sebagian kecil data dapat mengubah hasil model, yang menunjukkan bahwa kesimpulan penelitian tersebut mungkin tidak berlaku di luar batasan sempitnya.

Para peneliti ingin melihat apakah analisis yang sama dapat diterapkan pada platform pemeringkatan LLM.

“Pada akhirnya, pengguna ingin mengetahui apakah mereka memilih LLM terbaik. Jika hanya beberapa petunjuk yang mendorong peringkat ini, hal ini menunjukkan bahwa peringkat tersebut mungkin bukanlah akhir segalanya,” kata Broderick.

Namun tidak mungkin menguji fenomena penurunan data secara manual. Misalnya, satu peringkat yang mereka evaluasi mempunyai lebih dari 57.000 suara. Menguji penurunan data sebesar 0,1 persen berarti menghapus setiap subkumpulan 57 suara dari 57.000 suara, (ada lebih dari 10194subset), dan kemudian menghitung ulang peringkatnya.

Sebaliknya, para peneliti mengembangkan metode perkiraan yang efisien, berdasarkan penelitian mereka sebelumnya, dan mengadaptasinya agar sesuai dengan sistem peringkat LLM.

“Meskipun kami memiliki teori untuk membuktikan bahwa perkiraan tersebut berhasil berdasarkan asumsi tertentu, pengguna tidak perlu memercayai hal tersebut. Metode kami pada akhirnya akan memberi tahu pengguna titik data yang bermasalah, sehingga mereka dapat membuang titik data tersebut, menjalankan kembali analisis, dan memeriksa apakah ada perubahan pada peringkatnya,” katanya.

Sangat sensitif

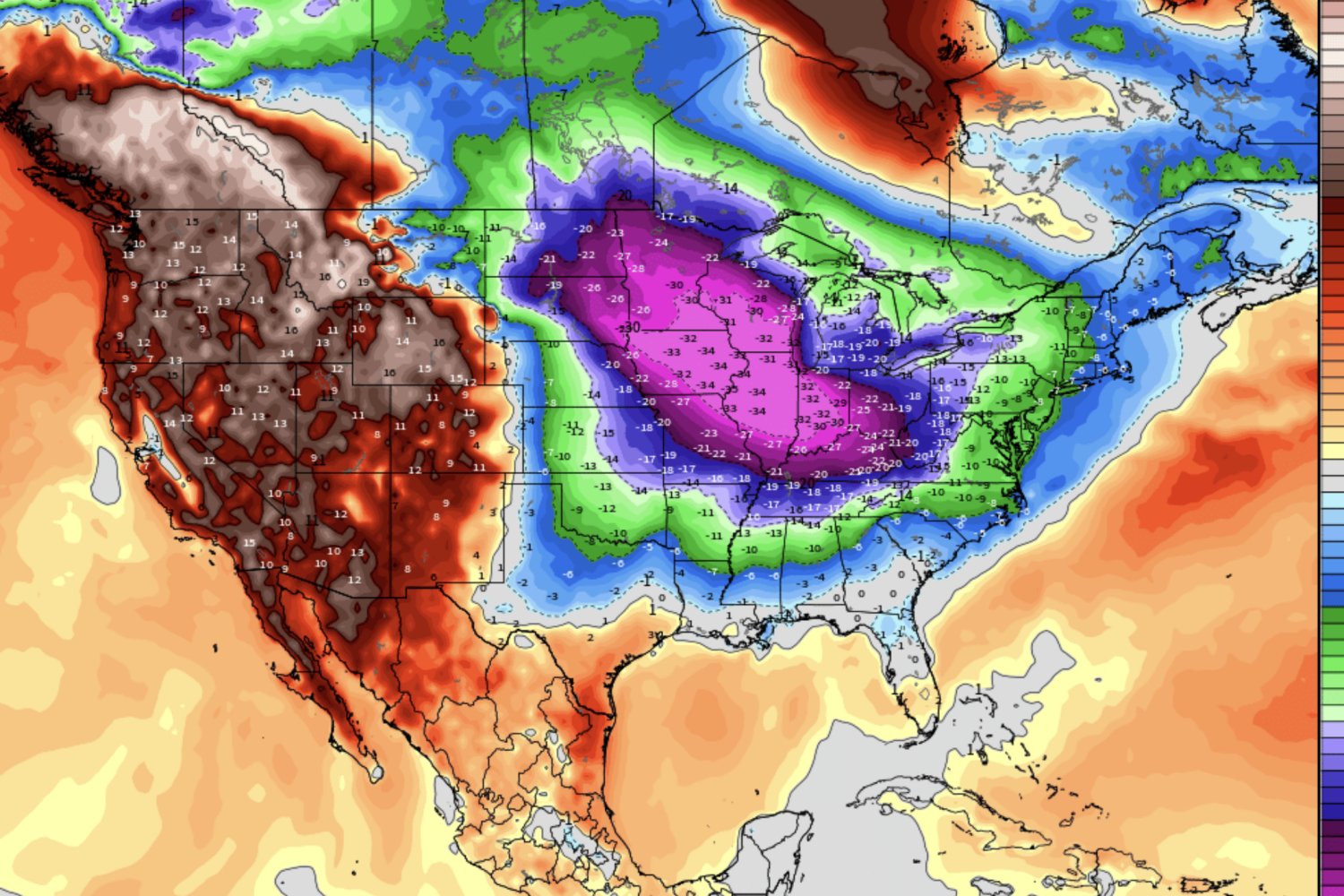

Ketika para peneliti menerapkan teknik mereka pada platform pemeringkatan populer, mereka terkejut melihat betapa sedikitnya titik data yang perlu mereka hilangkan untuk menyebabkan perubahan signifikan pada LLM teratas. Dalam satu contoh, menghilangkan hanya dua suara dari lebih dari 57.000, yaitu 0,0035 persen, mengubah model mana yang menduduki peringkat teratas.

Platform pemeringkatan yang berbeda, yang menggunakan anotator ahli dan petunjuk berkualitas lebih tinggi, lebih tangguh. Di sini, menghapus 83 dari 2.575 evaluasi (sekitar 3 persen) membalikkan model teratas.

Pemeriksaan mereka mengungkapkan bahwa banyak suara yang berpengaruh mungkin disebabkan oleh kesalahan pengguna. Dalam beberapa kasus, tampaknya ada jawaban yang jelas mengenai LLM mana yang berkinerja lebih baik, namun pengguna memilih model lain, kata Broderick.

“Kita tidak pernah tahu apa yang ada dalam pikiran pengguna pada saat itu, tapi mungkin mereka salah mengklik atau tidak memperhatikan, atau sejujurnya mereka tidak tahu mana yang lebih baik. Hal penting di sini adalah Anda tidak ingin kebisingan, kesalahan pengguna, atau hal-hal lain yang menentukan LLM mana yang berperingkat teratas,” tambahnya.

Para peneliti berpendapat bahwa mengumpulkan masukan tambahan dari pengguna, seperti tingkat kepercayaan dalam setiap suara, akan memberikan informasi yang lebih kaya yang dapat membantu mengurangi masalah ini. Platform pemeringkatan juga dapat menggunakan mediator manusia untuk menilai respons yang dilakukan melalui crowdsourcing.

Bagi para peneliti, mereka ingin terus mengeksplorasi generalisasi dalam konteks lain sembari mengembangkan metode perkiraan yang lebih baik yang dapat menangkap lebih banyak contoh ketidakkokohan.

“Pekerjaan Broderick dan murid-muridnya menunjukkan bagaimana Anda bisa mendapatkan perkiraan valid tentang pengaruh data tertentu pada proses downstream, meskipun perhitungan yang mendalam sulit dilakukan mengingat ukuran model dan kumpulan data pembelajaran mesin modern,” kata Jessica Hullman, Profesor Ilmu Komputer Ginni Rometty di Northwestern University, yang tidak terlibat dalam pekerjaan ini. “Penelitian terbaru ini memberikan gambaran sekilas tentang ketergantungan data yang kuat dalam metode yang diterapkan secara rutin – namun juga sangat rapuh – untuk menggabungkan preferensi manusia dan menggunakannya untuk memperbarui model. Melihat betapa sedikit preferensi yang benar-benar dapat mengubah perilaku model yang telah disesuaikan dapat menginspirasi metode yang lebih bijaksana dalam mengumpulkan data ini.”

Penelitian ini sebagian didanai oleh Office of Naval Research, MIT-IBM Watson AI Lab, National Science Foundation, Amazon, dan CSAIL seed award.